Superkomputer Eos pobił rekord czasu szkolenia AI

Nvidia pobiła własne rekordy w dziedzinie szkolenia AI i wysokowydajnych obliczeń. Firma zademonstrowała możliwości swojego superkomputera Eos, ustanawiając nowe benchmarki w najnowszych testach branżowych MLPerf, kończąc symulację treningu modelu GPT-3 w czasie poniżej 4 minut. Co ciekawe, zaledwie sześć miesięcy temu ten sam test trwał prawie 11 minut.

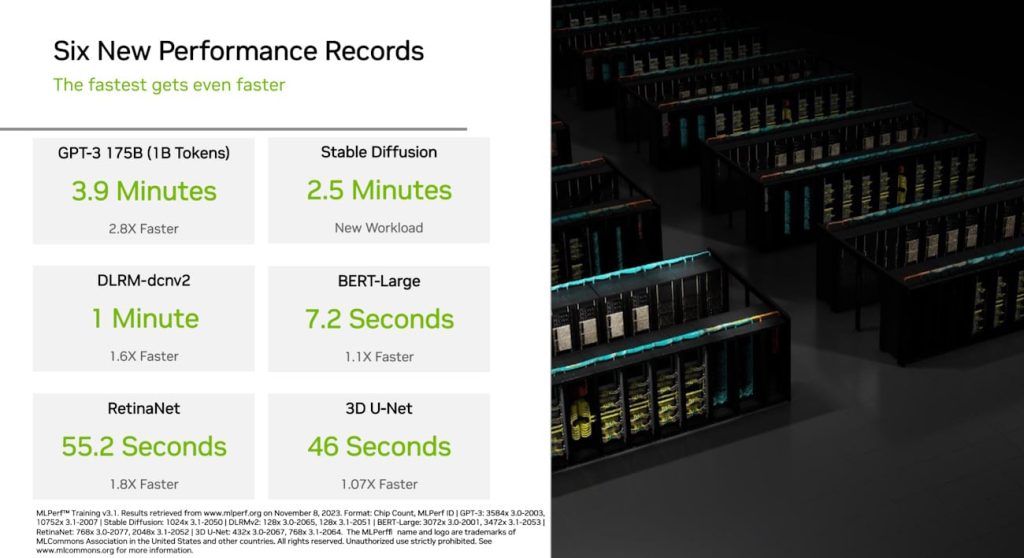

Szczegóły dotyczące wydajności Eos zostały udostępnione przez Nvidię na jej blogu, co oznacza pierwszą publikację danych tej potężnej maszyny. Branża zazwyczaj ujawnia informacje o wydajności za pośrednictwem standardowych testów MLPerf co sześć miesięcy, co oznacza, że jest to aktualizacja poprzednich danych, a Eos jest teraz w pełni operacyjny. Superkomputer wyposażony jest w 10 752 procesory graficzne H100 Tensor Core, połączone za pośrednictwem sieci Quantum-2 InfiniBand. Eos zademonstrował swoje możliwości, przetwarzając benchmark oparty na GPT-3, obejmujący 175 miliardów parametrów wytrenowanych na 1 miliardzie tokenów, w zaledwie 3,9 minuty — co oznacza 3-krotny wzrost wydajności w ciągu sześciu miesięcy.

Eos mógłby wytrenować AI na pełnym zestawie danych GPT-3 w zaledwie osiem dni

Nvidia przyznaje, że benchmark wykorzystuje tylko ułamek pełnego zestawu danych GPT-3 używanego przez ChatGPT. Sugeruje jednak, na podstawie tych wyników, że Eos potencjalnie mógłby wytrenować cały zestaw w zaledwie osiem dni, co oznacza znaczną 73-krotną poprawę w stosunku do technologii dostępnej w momencie wprowadzenia GPT-3 w 2020 roku. Warto zauważyć, że w tamtym czasie szczyt wydajności był reprezentowany przez 512 procesorów graficznych A100 Ampere, co ilustruje znaczny postęp w możliwościach obliczeniowych.

Nvidia podkreśla, że Eos został zaprojektowany nie tylko jako prezentacja możliwości, ale także jako plan wydajności superkomputerów w domenie sztucznej inteligencji, przeznaczony do użytku przez producentów oryginalnego sprzętu (OEM) i partnerów w chmurze. Znaczący wzrost wydajności przypisuje się bezprecedensowemu wykorzystaniu 10 752 procesorów graficznych H100, co stanowi znaczny wzrost w porównaniu z 3584 procesorami Hopper zastosowanymi w czerwcu.

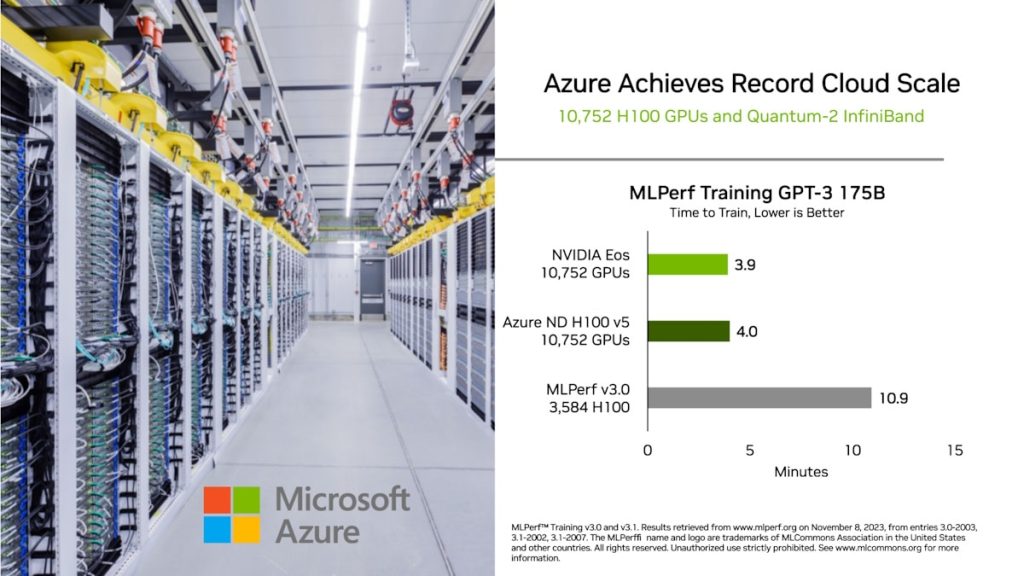

Intrygujące jest porównanie z wdrożeniem chmury Azure firmy Microsoft, która również wykorzystuje 10 752 procesory graficzne H100. Nvidia twierdzi, że obie firmy osiągnęły porównywalną wydajność, przy czym Nvidia odniosła nieznaczne zwycięstwo, ponieważ Azure ukończył benchmark GPT-3 w 4 minuty. Nvidia twierdzi, że wynik ten podkreśla wydajność procesorów graficznych H100 zarówno w centrach danych, jak i środowiskach chmurowych.

Miłośnik nowoczesnych technologii, głównie nowych rozwiązań IT. Redaktor w czasopismach Gambler, Enter, PC Kurier, Telecom Forum, Secret Service, Click!, Komputer Świat Gry, Play, GameRanking. Wiele lat spędził w branży tłumaczeniowej – głównie gier i programów użytkowych. W wolnych chwilach lata szybowcem, jeździ na rowerze i pochłania duże ilości książek.