Microsoft i Nvidia tworzą jeden z największych modeli językowych na świecie

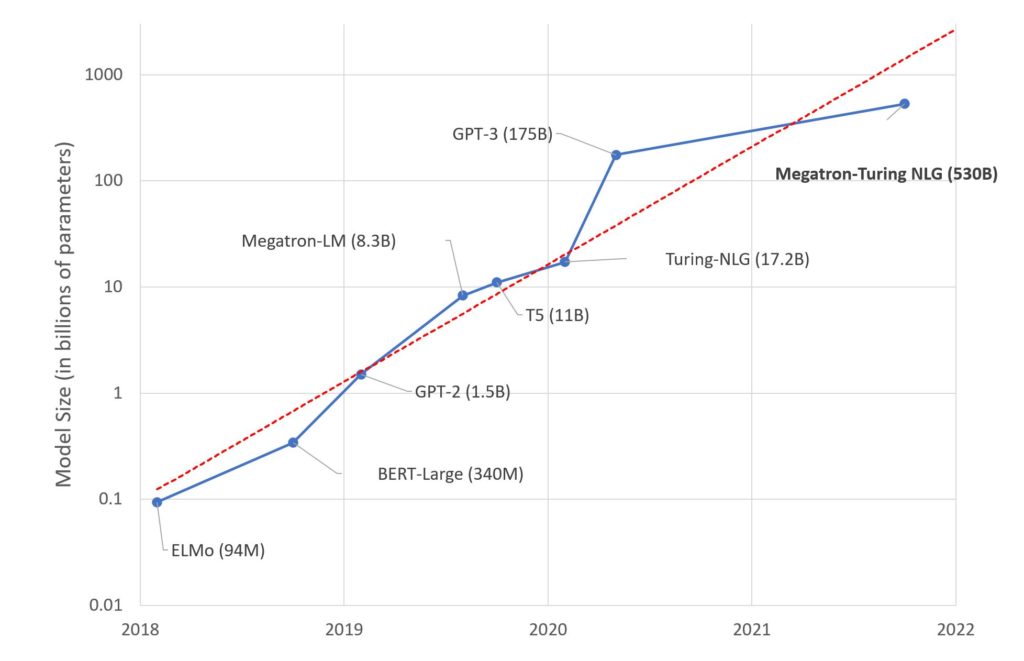

Microsoft i Nvidia ogłosiły, że wspólnymi siłami tworzą Megatron-Turing Natural Language Generation (MT-NLP). Ma to być największy i najwydajniejszy model językowy wykorzystujący sztuczną inteligencję. Zawiera on 530 mld parametrów i osiąga bardzo wysoką dokładność w szerokim zestawie zadań języka naturalnego. Chodzi o czytanie ze zrozumieniem, rozumowanie zdroworozsądkowe i wnioskowania z języka naturalnego.

„Jakość i wyniki, które dzisiaj osiągnęliśmy, to duży krok naprzód na drodze do odblokowania pełnej obsługi języka naturalnego przez sztuczną inteligencję. DeepSpeed i Megatron-LM przyniosą korzyści przy opracowywaniu istniejących i przyszłych modeli sztucznej inteligencji oraz sprawią, że duże modele sztucznej inteligencji będą tańsze i szybsze w szkoleniu. Nie możemy się doczekać, gdy MT-NLG ukształtuje przyszłe produkty i zmotywuje społeczność do dalszego przesuwania granic przetwarzania języka naturalnego (NLP). Przed nami jeszcze daleka droga, ale jesteśmy podekscytowani tym, co jest możliwe teraz i tym, co jeszcze jest przed nami.” – powiedzieli Paresh Kharya (Nvidia) i Ali Alvi (Microsoft).

Modele językowe pokazem mocy sztucznej inteligencji i metod uczenia maszynowego

W sierpniu pisaliśmy o modelu językowym AI21 Labs Jurrasic-1, który konkuruje z popularnym i docenianym OpenAI GPT-3. Miesiąc później ukazała się informacja o tym, że potężny model GPT-3 zostanie zastąpiony mocniejszym o ponad 500 razy modelem językowym OpenAI GPT-4. Warto nadmienić, że GPT-3 miał 175 mld parametrów.

Model językowy tworzony przez firmy Microsoft i Nvidia, czyli Megatron-Turing Natural Language Generation (MT-NLP) ma składać się z 530 mld parametrów. To nieco mniej niż deklaruje OpenAI w przygotowywanym przez siebie GPT-4, ale zanim tamten powstanie, minie jeszcze nieco czasu.

Microsoft i Nvidia tworzą model językowy Megatron-Turing Natural Language Generation (MT-NLP)

Microsoft i Nvidia twierdzą, że szkolą swój model językowy Megatron-Turing Natural Language Generation (MT-NLP) bazą fraz pozyskanych z anglojęzycznych stron internetowych. Całość zawiera aż 270 mld rekordów.

Użyte frazy zawierają słowa, znaki i sposoby dzielenia zdań na mniejsze części, tak jak ma to miejsce w języku naturalnym. Dodatkowo uczenie maszynowe przewidywało uwzględnianie reguł gramatycznych i syntaktycznych.

Sprzęt użyty do szkolenia maszynowego modelu językowego

Całość szkolenia modelu językowego odbywała się przy wykorzystaniu aż 560 serwerów Nvidia DGX A100. Każdy z nich wykorzystywał po 8 procesorów graficznych Nvidia A100 80 GB.

Entuzjasta technologii IT, mobile, wearables. Freelancer, od lat w branży mediów IT/Mobile (CD-Action, NeXT, PC Format, CafePC.pl, Benchmark.pl, Mobility, Komputer Świat, Bezprawnik, Startupmag, IoTLab.pl) , były PRowiec (Sweex i Hannspree) i logistyk. Pasjonat jedzenia, gotowania, zdrowego odżywiania, wędrówek, jazdy na rowerze, książek, kina, opery, teatru i wielu innych.