Intel Labs udostępnia modele AI do określania głębi w obrazach i zdjęciach: VI-Depth 1.0 i MiDaS 3.1

Intel Labs kontynuuje prace nad udoskonaleniem rozwiązań do określania głębi dla społeczności zajmującej się widzeniem komputerowym, wprowadzając VI-Depth w wersji 1.0 oraz wydając MiDaS w wersji 3.1.

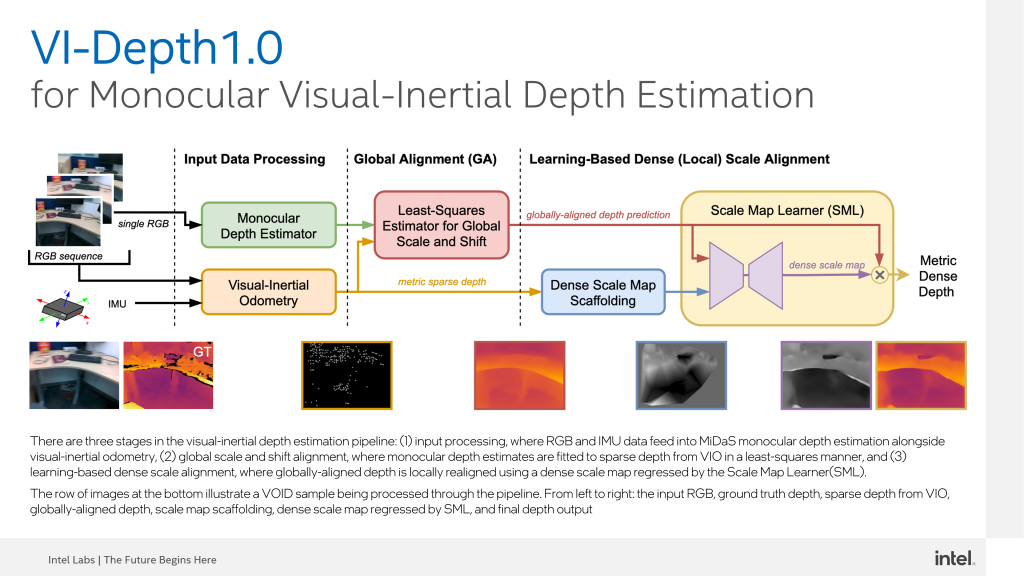

VI-Depth to potok wizualno-inercyjnej estymacji głębi, który integruje monokularną estymację głębi i wizualną odometrię inercyjną (VIO) w celu uzyskania gęstych estymacji głębi z metryczną skalą. Podejście to wykonuje globalne wyrównanie skali i przesunięcia względem nielicznych metrycznych głębokości, a następnie oparte na uczeniu wyrównanie gęstości. Percepcja głębi jest fundamentalna dla nawigacji wizualnej, a poprawne oszacowanie odległości może pomóc w planowaniu ruchu i unikaniu przeszkód. Niektóre aplikacje wymagają dokładnego szacowania głębokości, gdzie każda wartość głębokości jest podana w bezwzględnych jednostkach metrycznych i reprezentuje fizyczną odległość. Dokładna estymacja głębokości w VI-Depth może pomóc w rekonstrukcji sceny, mapowaniu i manipulacji obiektami.

VI-Depth jest dostępny na licencji open-source MIT na GitHubie.

Intel Labs integruje MiDaS ze Stable Diffusion

Dzięki dużej wydajności w szacowaniu względnej głębokości każdego piksela w obrazie wejściowym, MiDaS jest przydatny w szerokim zakresie zastosowań, w tym w robotyce, rzeczywistości rozszerzonej (AR), rzeczywistości wirtualnej (VR) i wizji komputerowej.

Intel Labs zintegrował niedawno biblioteki MiDaS z programem Stable Diffusion 2.0, który jest modelem AI typu tekst-obraz, zdolnym do generowania fotorealistycznych obrazów na podstawie wprowadzonego tekstu. Integracja z MiDaS wprowadza nową funkcję depth-to-image dla syntezy obrazów z zachowaniem struktury oraz syntezy obrazów warunkowych pod względem kształtu. Stable Diffusion rozpoznaje głębię obrazu wejściowego za pomocą MiDaS, a następnie generuje nowe obrazy z wykorzystaniem zarówno tekstu, jak i informacji o głębi. Dzięki integracji z MiDaS, model głębokościowy Stable Diffusion może tworzyć obrazy, które wyglądają radykalnie inaczej niż oryginał, ale nadal zachowują geometrię, umożliwiając różnorodne zastosowania.

Innym przykładem sukcesu tego modelu są 360-stopniowe środowiska VR stworzone przez cyfrowego twórcę Scottiego Foxa przy użyciu kombinacji Stable Diffusion i MiDaS. Eksperymenty te mogą potencjalnie doprowadzić do nowych zastosowań wirtualnych, w tym rekonstrukcji miejsc zbrodni na potrzeby spraw sądowych, środowisk terapeutycznych dla służby zdrowia oraz gier.

MiDaS 3.1 jest dostępny na GitHubie, gdzie otrzymał ponad 2600 gwiazdek od społeczności.

Miłośnik nowoczesnych technologii, głównie nowych rozwiązań IT. Redaktor w czasopismach Gambler, Enter, PC Kurier, Telecom Forum, Secret Service, Click!, Komputer Świat Gry, Play, GameRanking. Wiele lat spędził w branży tłumaczeniowej – głównie gier i programów użytkowych. W wolnych chwilach lata szybowcem, jeździ na rowerze i pochłania duże ilości książek.