Czy sztuczną inteligencję da się kontrolować?

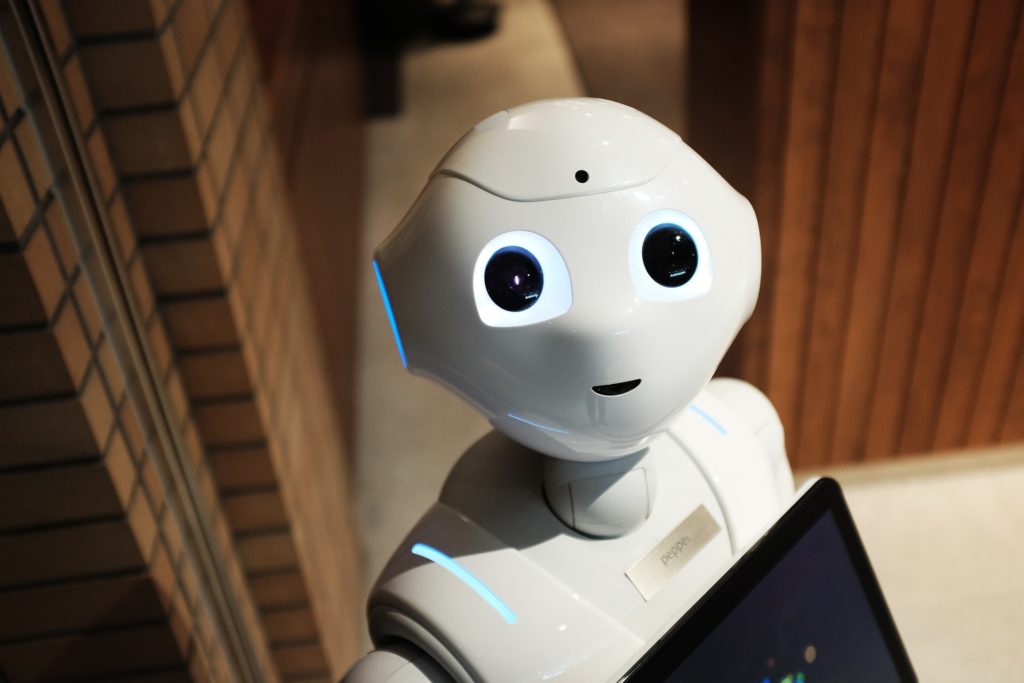

Coraz więcej otaczających nas urządzeń wyposażanych jest w sztuczną inteligencję. Mają one pomagać nam w codziennych sprawach i czynić życie lżejszym, bezpieczniejszym i przyjemniejszym. Co jednak, gdy wyrwie się ona na wolność? Czy to w ogóle możliwe?

Naukowcy opublikowali w Journal of Artificial Intelligence Research badanie, z którego wynika, że tworzenie bardzo wydajnego i autonomicznego oprogramowania wiąże się ze sporym ryzykiem. Korzystając z serii obliczeń teoretycznych, badacze sprawdzili, czy można kontrolować sztuczną inteligencję. Wniosek jest jeden i trochę mrozi krew w żyłach. Wyniki wskazują, że realizacja takiego zadania jest niemożliwa.

„Superinteligentna maszyna, która kontroluje świat, brzmi jak fantastyka naukowa. Ale przecież są już takie, które samodzielnie wykonują ważne zadania, a programiści dokładnie nie wiedzą, w jaki sposób się ich nauczyły. To sytuacja, nad którą możemy stracić kontrolę, a to stwarza niebezpieczeństwo dla całej ludzkości” – powiedział Manuel Cebrian, współautor badania z Max Planck Institute for Human Development.

Eksperymenty na dwa sposoby

Naukowcy eksperymentowali z dwoma sposobami kontrolowania sztucznej inteligencji. Jednym z nich było odizolowanie jej od internetu i innych urządzeń, izolując ją w ten sposób od świata zewnętrznego. Problem w tym, że znacznie ograniczyłoby to jej zdolność do wykonywania funkcji, dla których przecież została stworzona. Drugim było zaprojektowanie teoretycznego „algorytmu powstrzymywania”, aby sztuczna inteligencja „nie mogła wyrządzić ludziom krzywdy niezależnie od okoliczności”. Chodziło o stworzenie czegoś na kształt praw robotów Asimova. Analiza wykazała jednak, że napisanie takiego algorytmu jest niemożliwe.

„Jeśli rozłożymy problem na podstawowe elementy, okaże się, że algorytm, który nakazuje sztucznej inteligencji nie niszczyć świata, może nieumyślnie zatrzymać własne działanie. Gdyby tak się stało, nie wiedzielibyśmy, czy kontynuowałby analizę zagrożenia czy też przestałby powstrzymywać sztuczną inteligencję. Okazuje się więc, że mógłby być bezużyteczny” – wyjaśnił Iyad Rahwan, szef Center for Humans and Machines.

Skoro więc nie potrafimy stworzyć ograniczeń dla SI, a odcięcie jej od świata zewnętrznego sprawi, że stanie się ona bezużyteczna, to ludzkość powinna zaprzestać rozwoju tej technologii? Sądzimy, że nie, ale aby scenariusz z Terminatora się nie zrealizował, powinniśmy robić to bardzo ostrożnie. Miejmy jednak świadomość, że powstanie superinteligentnych maszyn może nadejść niespodziewanie. Powstrzymanie SI od wyprzedzenia ludzi należy do dokładnie tej samej sfery co uniemożliwienie jej robienia im krzywdy. Może więc czas na powołanie policji Turinga istniejącej na razie na kartach książek Williama Gibsona, a zajmującej się kontrolą SI?

Źródło: Entrepreneur

Miłośnik nowoczesnych technologii, głównie nowych rozwiązań IT. Redaktor w czasopismach Gambler, Enter, PC Kurier, Telecom Forum, Secret Service, Click!, Komputer Świat Gry, Play, GameRanking. Wiele lat spędził w branży tłumaczeniowej – głównie gier i programów użytkowych. W wolnych chwilach lata szybowcem, jeździ na rowerze i pochłania duże ilości książek.