Czy system Facebook AI Ego4D i okulary AR zastąpią smartfony?

Od lat dział Facebook AI pracuje nad systemami sztucznej inteligencji, ale dopiero system Ego4D pokazuje, co będzie mógł zrobić gigant ze swoimi okularami AR (augmented reality – rzeczywistość rozszerzona) opracowywanymi z firmą RayBan. System będzie w stanie widzieć, słyszeć i zapamiętywać wszystko, co robi człowiek i przetwarzać te dane według uznania.

„Systemy AI nowej generacji będą musiały uczyć się z zupełnie innego rodzaju danych — filmów, które pokazują świat z centrum akcji, a nie z boku” – powiedziała Kristen Grauman, główny naukowiec projektu.

Facebook AI tworzy system Ego4D

Sztuczna inteligencja, która będzie w stanie postrzegać świat z perspektywy pierwszej osoby, może pomagać nam lepiej, niż taka, która obserwuje świat z boku. Perspektywa sporo zmienia, co pokazało wiele doświadczeń i eksperymentów.

„Chodzi o to, że jeśli chcemy zbudować tego typu nowe technologie, musimy nauczyć sztuczną inteligencję rozumienia świata i interakcji z nim, w taki sposób jak odbieramy to my, czyli z perspektywy pierwszej osoby. Jest ona powszechnie określana w społeczności naukowej jako percepcja egocentryczna. Dzisiejsze systemy widzenia komputerowego (CV) zazwyczaj jednak uczą się z milionów zdjęć i filmów uchwyconych z perspektywy trzeciej osoby, gdzie kamera jest tylko widzem akcji” – podkreśliła Ritika Trikha, członek zespołu Facebook AI.

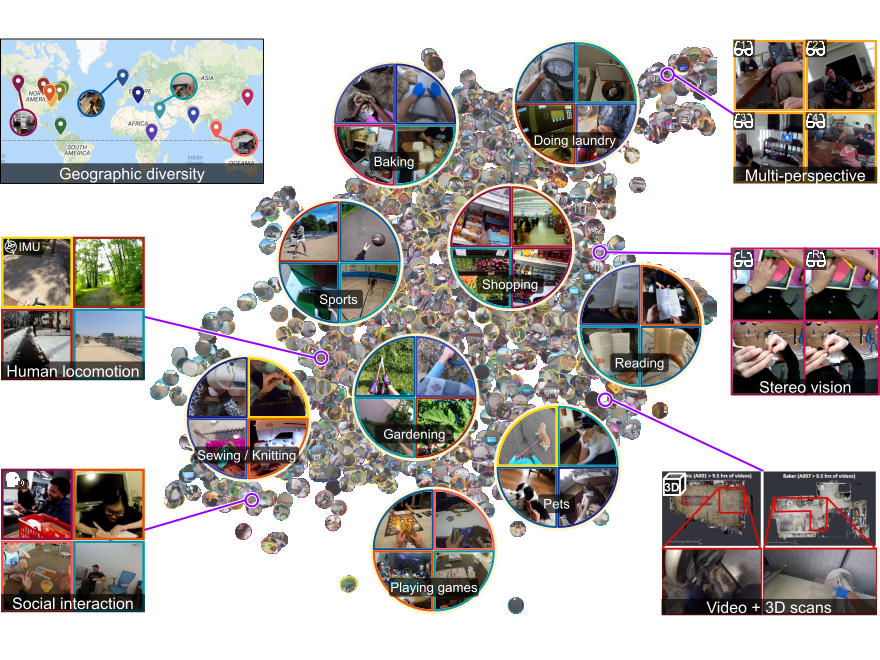

Ego4D jest projektem, który poprawi percepcję otoczenia użytkownika systemów AR. Facebook zaprosił do współpracy nad systemem 13 uniwersytetów i laboratoriów z dziewięciu krajów.

Pomogły one zebrać i przeanalizować ponad 3000 godzin materiału wideo i audio pozyskanego z perspektywy pierwszej osoby. Udział w gromadzeniu danych wzięło ponad 700 ludzi. Całość została sfinansowana przez Facebooka.

W czym może nam pomagać tak zaawansowana rzeczywistość rozszerzona?

Uniwersytety, laboratoria, Facebook Reality Labs Research (FRL Research) i Facebook AI skupiły się na pięciu podstawowych działaniach systemu Ego4D.

Są nimi:

- Pamięć epizodyczna: Co się stało, kiedy? Sztuczna inteligencja może odpowiadać na dowolne pytania i poszerzać pamięć osobistą, odzyskując kluczowe momenty ze zgromadzonych filmów. Aby to zrobić, model musi zlokalizować odpowiedź na zapytanie w zapisanych klatkach filmu i przekazać informacje przydatne w trójwymiarowym środowisku. Możesz zadać swojemu asystentowi AI lub robotowi domowemu pytania, takie jak „Gdzie zostawiłem ulubionego misia mojego dziecka?”

- Prognozowanie: Co zrobię dalej? Sztuczna inteligencja może zrozumieć, w jaki sposób działania użytkownika mogą wpłynąć na przyszły stan świata, pod względem tego, gdzie dana osoba może się poruszać, jakich przedmiotów prawdopodobnie dotknie, lub jaką aktywność prawdopodobnie podejmie w następnej kolejności. Prognozowanie działań wymaga nie tylko rozpoznania tego, co się wydarzyło, ale także wybiegania w przyszłość, aby przewidzieć kolejne ruchy. Umożliwi to przyszłym systemom sztucznej inteligencji, które w danej chwili będą dostarczać pomocne wskazówki. Na przykład, gdy masz zamiar chwycić solniczkę, Twój asystent AI może wysłać powiadomienie typu „Czekaj, już dodałeś sól.”

- Interakcja ręka-obiekt: Co robię i jak? Nauka interakcji rąk z przedmiotami ma kluczowe znaczenie dla treningów i instruowania przy codziennych zadaniach. Sztuczna inteligencja musi wykrywać pierwszoosobowe interakcje człowiek-obiekt, rozpoznawać manipulację dłońmi i wykrywać zmiany stanu obiektów. Może się to przydać, gdy ktoś przygotowuje potrawę, a asystent AI może poinstruować użytkownika, jakich składników potrzebuje i co musisz z nimi zrobić najpierw, zrozumieć, co już zrobił, i poprowadzić przez całość procesu dosłownie za rękę.

- Dziennik audiowizualny: Kto, co i kiedy powiedział? Ludzie używają dźwięku, aby zrozumieć świat i określić, kto, co i kiedy powiedział. Jeśli uczestniczymy w dyskusji, ale ciągle coś lub ktoś nas rozprasza, to można później zapytać asystenta AI: „Jakie były główne tematy podczas dzisiejszej dyskusji?”

- Interakcje społeczne: Jak wchodzimy w interakcje? Poza rozpoznawaniem sygnałów wizualnych i dźwiękowych, zrozumienie interakcji społecznych jest podstawą każdego inteligentnego asystenta AI. Inteligentna społecznie sztuczna inteligencja rozumiałaby, kto do kogo mówi, a kto na kogo zwraca uwagę. Tak więc następnym razem, gdy będziesz na przyjęciu, asystent AI może pomóc ci lepiej skoncentrować się na tym, co mówi osoba rozmawiająca z tobą przy stole w hałaśliwym środowisku.

Okulary AR rozszerzą znacznie możliwości lub wręcz zastąpią nasze smartfony

Facebook AI twierdzi, że wkrótce okulary AR (augmented reality – rzeczywistość rozszerzona) będą dla nas tym, czym stały się smartfony. Wspomogą nas w bardzo zaawansowany sposób. Specjalne przezierne wyświetlacze są w stanie wyświetlić nam wirtualne wskazówki dotarcia do celu niezależnie od tego, czy jedziemy rowerem, samochodem, czy idziemy pieszo. W innym przypadku system dzięki wbudowanej w okulary kamerze rozpoznaje obiekty i podaje opis – może to być budynek, dzieło sztuki, owoc lub przedmiot. Jeszcze inny scenariusz przewiduje prowadzenie niejako za rękę podczas przygotowywania potrawy, naprawy jakiegoś urządzenia itp.

Dzięki AI znacznie łatwiej będzie uczyć się nowych czynności, skupiać w rozpraszającym uwagę środowisku, lepiej wykonywać wiele czynności, a także być znacznie efektywniejszym w pracy. Co więcej, systemy te wspomogą naszą pamięć, która może być zawodna.

Czy taka wizja wywołuje w Was entuzjazm, czy obawy o „permanentną inwigilację” życia naszego ludzi wokół?

Entuzjasta technologii IT, mobile, wearables. Freelancer, od lat w branży mediów IT/Mobile (CD-Action, NeXT, PC Format, CafePC.pl, Benchmark.pl, Mobility, Komputer Świat, Bezprawnik, Startupmag, IoTLab.pl) , były PRowiec (Sweex i Hannspree) i logistyk. Pasjonat jedzenia, gotowania, zdrowego odżywiania, wędrówek, jazdy na rowerze, książek, kina, opery, teatru i wielu innych.